JetBrains annonce l’intégration de PyCharm avec Databricks :

JetBrains annonce l’intégration de PyCharm avec Databricks :Un aperçu des avantages et cas d'usage

JetBrains annonce l’intégration de la plateforme de données Databricks avec son EDI PyCharm Professional, ce qui permet de simplifier le traitement, le stockage et l’analyse de vos données.

Cette intégration vous permet de créer vos applications de données et d’IA sur la Data Intelligence Platform de Databricks directement dans PyCharm Professional et de bénéficier de la puissance de l’EDI Python de JetBrains pour l’analyse des données. Elle vous donne la possibilité d’écrire du code rapidement et facilement et de l’exécuter dans le cloud sans configurations supplémentaires, et offre de nombreux autres avantages pour le travail avec les données.

Nous présentons dans la suite cette intégration, ses cas d’usage et les avantages qu’elle apporte.

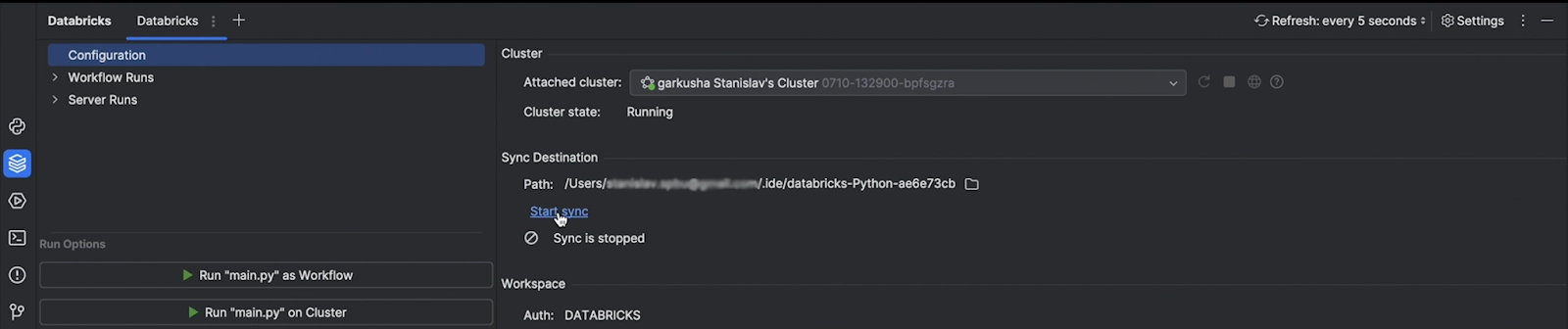

Le plugin Databricks en action

Qu’est-ce que Databricks ?

La Data Intelligence Platform de Databricks permet à l’ensemble de votre organisation d’utiliser les données et l’IA. Construite sur la base d’un lakehouse afin de fournir un socle ouvert et unifié pour toutes les données et la gouvernance, elle est alimentée par un moteur de Data Intelligence capable de comprendre le caractère unique de vos données.

Qu’est-ce que PyCharm Professional ?

PyCharm Professional est l’un des EDI les plus utilisés pour Python, ainsi que pour d’autres langages de programmation. Il vous permet d’écrire du code efficace et de haute qualité grâce à des fonctionnalités de saisie semi-automatique de code, de refactorisation et d’inspections de code ultra performantes, à une navigation fluide dans le code et dans les projets, à un débogueur puissant et à une large gamme d’intégrations, incluant notamment les notebooks Jupyter, les frameworks de tests, Git et des solutions de CI/CD, le tout directement disponible au même endroit.

Pour qui cette intégration est-elle utile ?

Pour les organisations et les professionnels des données utilisant des data lakehouses, data lakes et data warehouses via Databricks.

Quels sont les avantages qu’apporte cette intégration ?

Cette intégration combine les fonctionnalités les plus puissantes de chaque plateforme, ce qui vous permet de créer facilement toutes vos applications de données et d’IA à grande échelle dans PyCharm :

- Utilisez PyCharm pour implémenter les bonnes pratiques de développement logiciel essentielles pour les très grandes bases de code, telles que le contrôle du code source, les dispositions de code modulaires, les tests et bien d’autres.

- Databricks permet d’utiliser des clusters puissants, afin de pouvoir travailler sur des projets trop volumineux pour une machine locale et d’orchestrer efficacement le traitement des données.

Vous pouvez écrire le code pour vos pipelines et vos tâches dans PyCharm, puis le déployer, le tester et l’exécuter en temps réel sur votre cluster Databricks sans configurations supplémentaires.

Voyons plus en détail ce qu’apporte l’intégration de PyCharm avec Databricks.

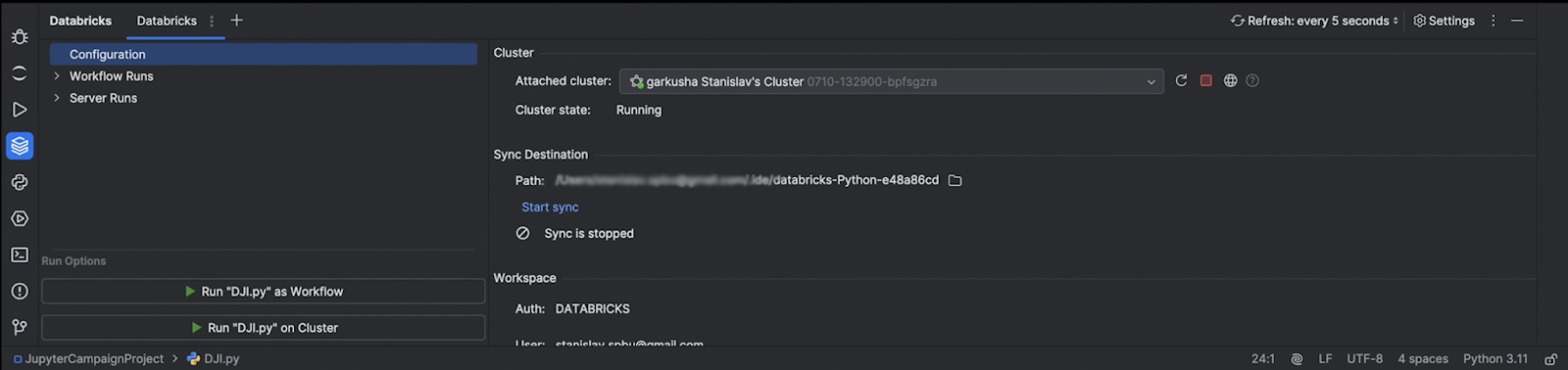

Connexion à votre cluster via PyCharm

Vous pouvez vous connecter directement au cluster Databricks via PyCharm et superviser le processus au sein de l’EDI. Cela vous permet de vérifier si le cluster est en cours d’exécution, de voir les résultats des exécutions de la session en cours et d’afficher des informations supplémentaires sur les processus d’exécution.

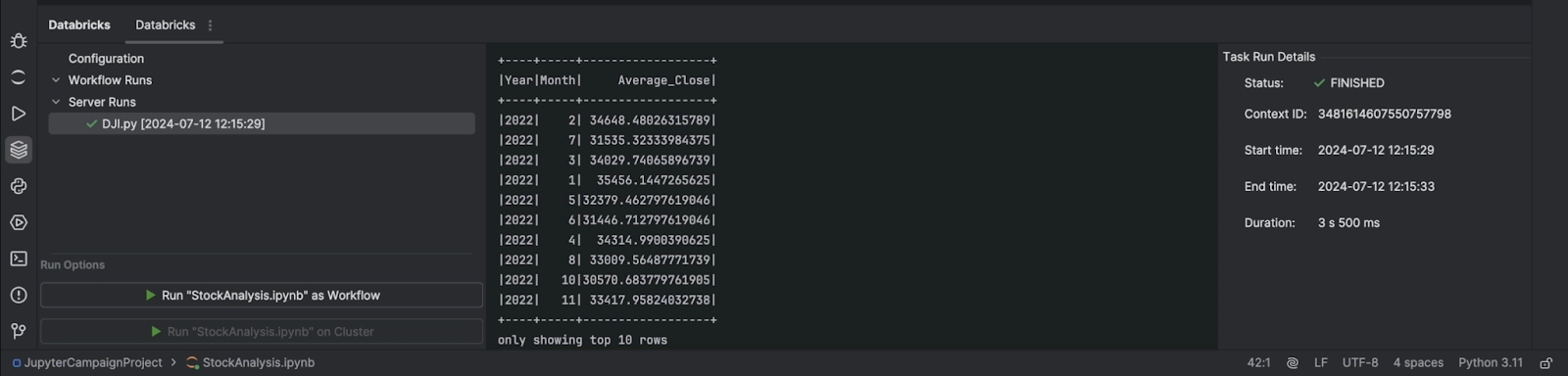

Exécution de scripts Python sur un cluster distant

Vous pouvez exécuter les scripts Python sur un cluster distant, ce qui est particulièrement utile pour les activités de big data, et visualiser les résultats dans l’EDI.

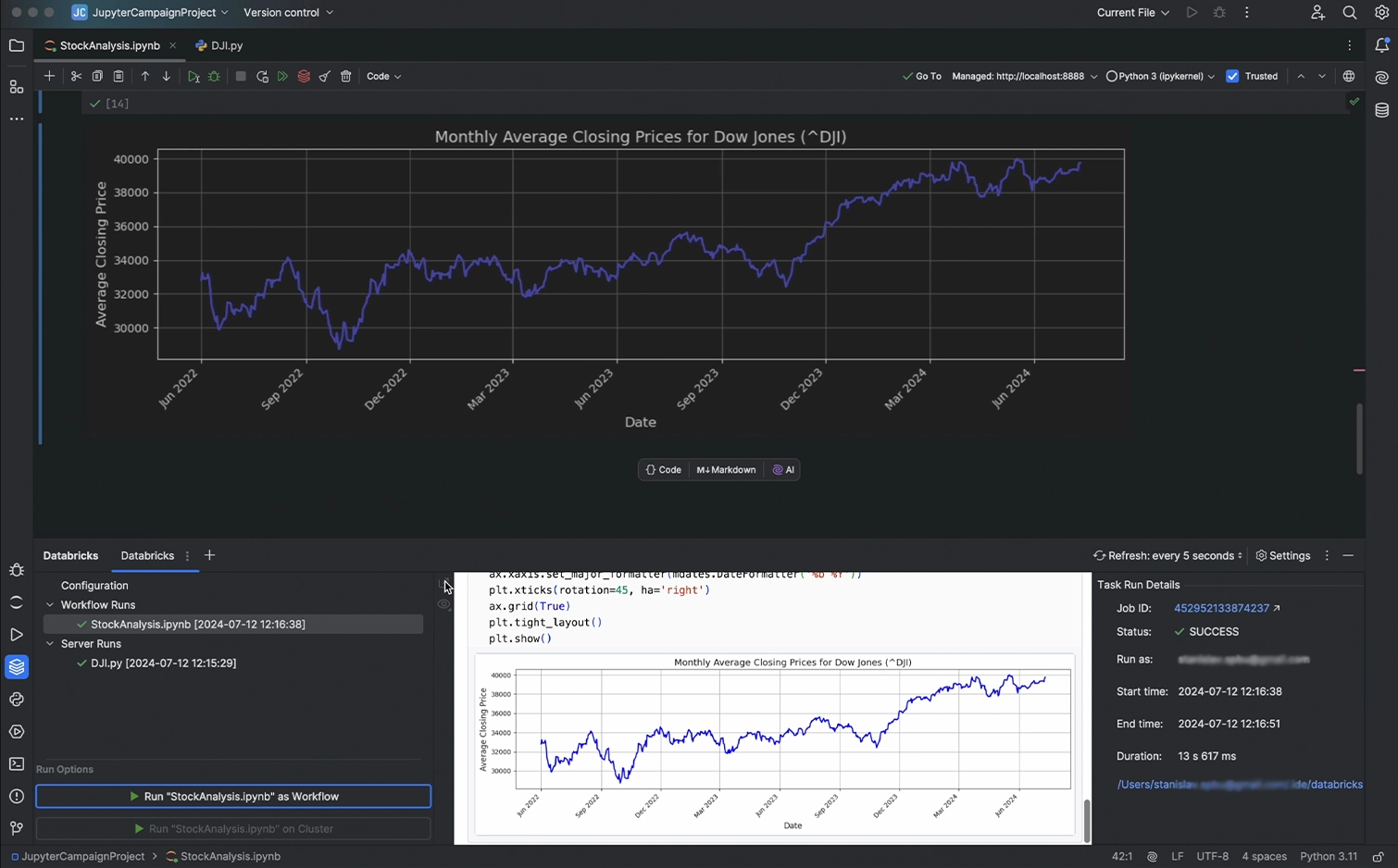

Exécution de notebooks Jupyter ou de scripts Python en tant que workflows

L’intégration vous permet aussi d’exécuter votre notebook ou vos scripts Python en tant que workflow Databricks et de voir la sortie dans la console.

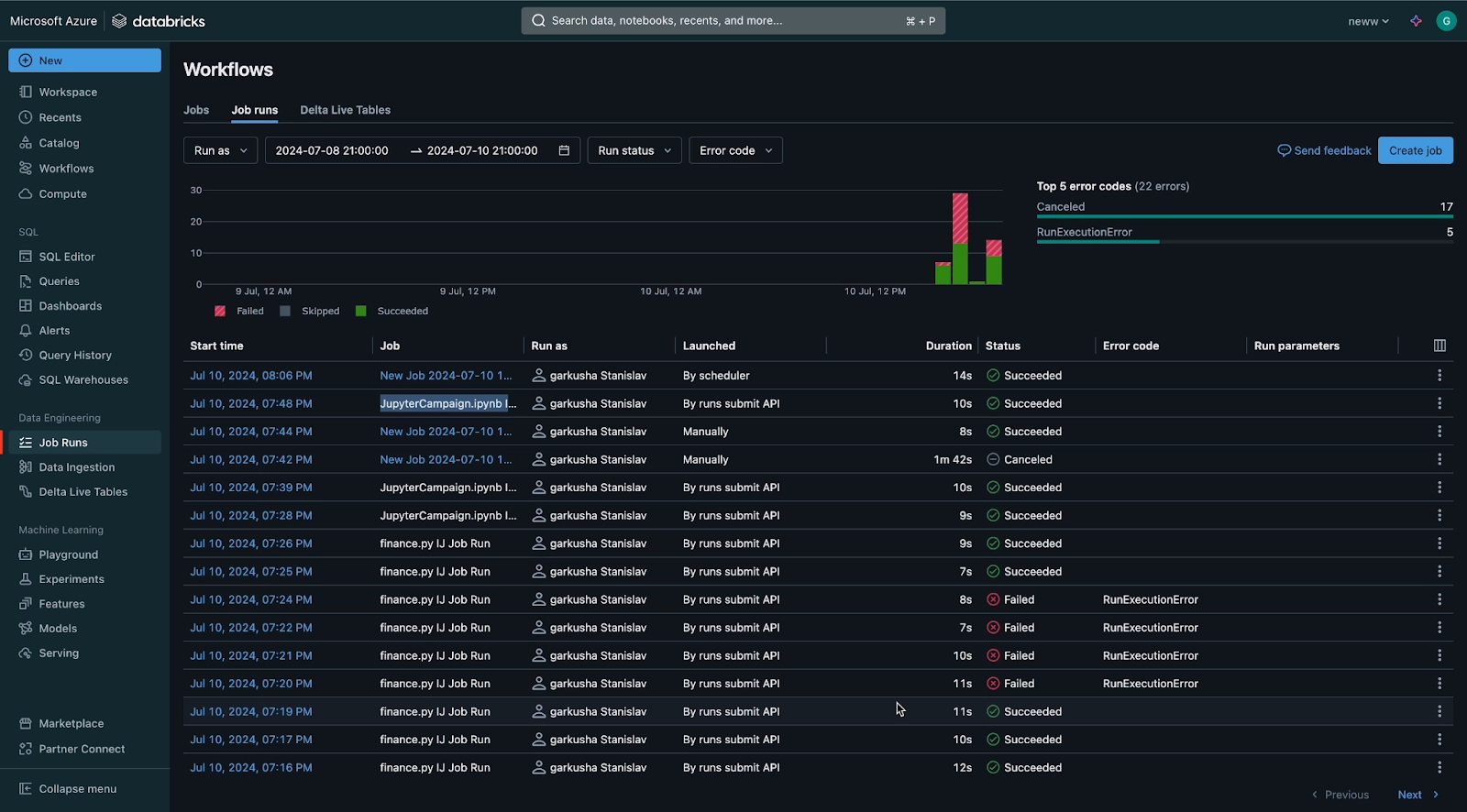

Les résultats des exécutions s’affichent sur la plateforme Databricks, y compris pour les exécutions initiées depuis PyCharm.

Synchronisation des fichiers des projets avec l’espace de travail de Databricks

La synchronisation des fichiers de projet avec l’espace de travail de Databricks vous permet d’avoir accès et de travailler avec mêmes fichiers dans les espaces de travail de PyCharm et de Databricks. Vous pouvez également planifier vos notebooks et vos scripts, et utiliser d’autres fonctionnalités de la plateforme pour les projets réalisés dans PyCharm.

Pour prendre un bon départ

Assurez-vous tout d’abord de disposer des éléments suivants :

- PyCharm Professional 2024.2 ou une version ultérieure

- Le plugin Big Data Tools Core

- Un compte Databricks

Vous pouvez installer le plugin Databricks depuis la Marketplace JetBrains ou directement dans l’EDI PyCharm.

Installer le plugin Databricks

Installer le plugin Databricks

Vous avez lu gratuitement 2 592 articles depuis plus d'un an.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.

Soutenez le club developpez.com en souscrivant un abonnement pour que nous puissions continuer à vous proposer des publications.